La mayoría de los técnicos de calibración continúan utilizando unos procedimientos en sus fábricas que no han evolucionado en paralelo con la tecnología de los instrumentos. Hace años, mantener una especificación de exactitud del ±1% del span era difícil, sin embargo, la instrumentación actual puede superar fácilmente ese umbral cada año. En algunos casos, los técnicos están utilizando equipos de calibración antiguos que no cumplen las nuevas especificaciones tecnológicas. Este documento pretende establecer pruebas de rendimiento básicas en las que el análisis de los parámetros de calibración (principalmente tolerancias, intervalos y puntos de calibración o test) se puedan evaluar y ajustar para lograr un rendimiento adecuado. También se tendrán en cuenta los posibles riesgos: parámetros vinculados con la reglamentación, con la seguridad, con la calidad, con la eficiencia, con las paradas y otros parámetros críticos. Entender correctamente estas variables será de gran ayuda para tomar mejores decisiones sobre cómo calibrar los equipos de medida de la planta y cómo mejorar prácticas o métodos obsoletos.

Introducción y antecedentes

La pregunta más básica a la que se enfrentan los profesionales de la calibración de una planta es con qué frecuencia se tiene que calibrar un instrumento de medida. La respuesta no es fácil, ya que son muchas las variables que influyen en el rendimiento del instrumento y, por tanto, en el correcto intervalo de calibración. Estas variables son:

- Recomendaciones del fabricante (un buen punto por el que empezar)

- Especificaciones de exactitud (accuracy) del fabricante

- Especificación de estabilidad (corto plazo frente a largo plazo)

- Requisitos del proceso

- Condiciones ambientales habituales (duras frente a controladas en laboratorio)

- Requisitos establecidos por reglamentaciones o normas de calidad

- Costes asociados a los fallos

La siguiente pregunta para establecer un buen programa de calibración es conocer cuál es la tolerancia para considerar una calibración “Aceptada” o “No aceptada”. De nuevo, la respuesta no es fácil, y las opiniones varían mucho sin tener demasiado en cuenta lo que es realmente necesario para que unas instalaciones funcionen con seguridad y, por supuesto, produzcan un producto de calidad con el máximo nivel de eficiencia. Un análisis de criticidad del instrumento sería un buen punto de partida. No obstante, la tolerancia está estrechamente relacionada con la primera pregunta sobre la

frecuencia de calibración. Una tolerancia «exigente» puede requerir revisiones o recalibraciones más frecuentes con un patrón de gran exactitud, mientras que una medición menos crítica que utilice un instrumento con un buen nivel de exactitud puede no requerir su calibración durante varios años.

La mejor manera de determinar y llevar a cabo los procedimientos y métodos de calibración adecuados es otra pregunta que necesita una repuesta. En la mayoría de los casos, los procedimientos y métodos que emplea una planta en concreto no han evolucionado con el tiempo. Muchas veces, los técnicos de calibración utilizan métodos que se establecieron muchos años atrás y no es extraño escuchar, «siempre lo hemos hecho así». Mientras tanto, la tecnología basada en la medición continúa mejorando y ganando en exactitud. También se está haciendo más compleja, ¿por qué calibrar un transmisor con bus de campo (fieldbus) de la misma forma que un transmisor neumático? Realizar una calibración estándar a 5 puntos subiendo y bajando con un error inferior al 1% o el 2% del span no siempre es lo adecuado para las aplicaciones actuales más sofisticadas. A medida que la tecnología de medición mejora, también lo deberían hacer los procedimientos y los métodos del técnico de calibración.

Finalmente, la dirección de la planta tiene que entender que cuanto más estricta o exigente sea la tolerancia, más costará realizar una medición correcta. Es un hecho que todos los instrumentos presentan un cierto grado de deriva. También hay que decir que cada marca/modelo de instrumento tiene una «personalidad» única de rendimiento en una aplicación de proceso específica. La única forma de determinar los parámetros de calibración correctos es registrar de alguna manera la calibración de forma que permita analizar la desviación y la deriva. Con unos buenos datos fiables y un buen equipo de calibración se puede mantener una baja tolerancia y equilibrarla con una planificación adecuada. Una vez establecidos estos parámetros, los costes asociados para realizar una calibración se pueden estimar y, ver si está justificado comprar un instrumento más sofisticado con mejores especificaciones de rendimiento o un patrón con mayor exactitud para conseguir un rendimiento del proceso todavía mejor.

Descarga gratis este artículo haciendo clic en la siguiente imagen:

Conceptos básicos sobre los procedimientos de calibración

Intervalo de calibración adecuado

Determinar el intervalo de calibración adecuado es una suposición argumentada basada en diversos factores. Una buena práctica es establecer un intervalo conservador basado en cuál sería el impacto de un fallo en términos de funcionamiento de manera segura, mientras se fabrica un producto con la máxima eficiencia y calidad. También es importante determinar si la calibración tendría un impacto mínimo en el funcionamiento de la planta. Centrándonos primero en los instrumentos más críticos, se puede determinar una planificación adecuada que permitiría menos calibraciones críticas si el personal tuviera disponibilidad.

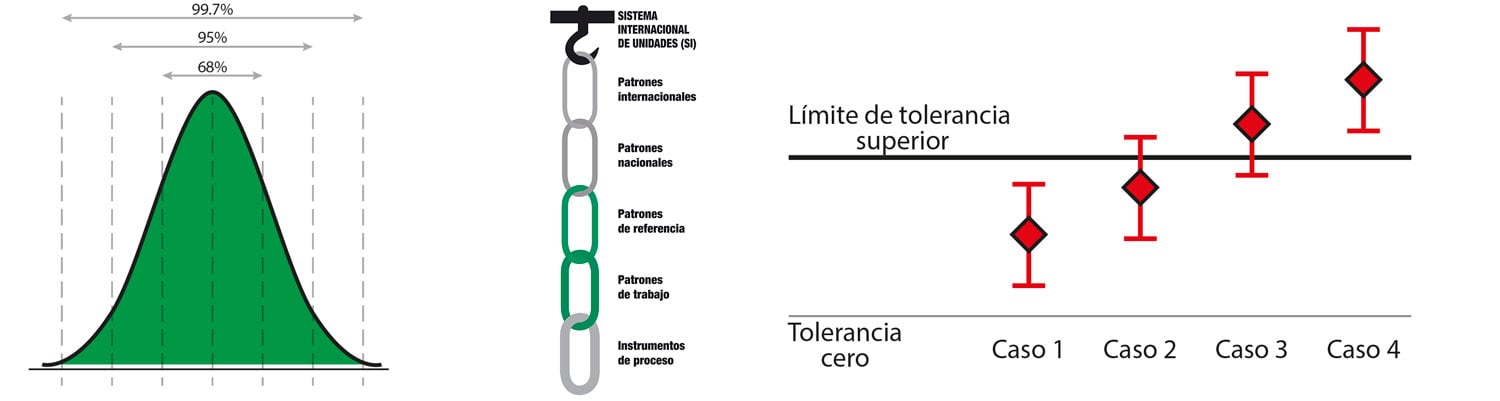

Como todos los instrumentos presentan deriva, independientemente de la marca/modelo/tecnología, los fabricantes acaban publicando especificaciones muy diferentes que dificultan la comparación del rendimiento. Muchas veces se incluyen complicadas observaciones al pie de página escritas en una terminología carente de coherencia. El rendimiento de un instrumento no siempre está relacionado con su precio. La única manera de determinar un intervalo adecuado es recopilar datos mediante la calibración y evaluar la deriva en el tiempo de una marca/modelo de instrumento concreto.

Empezando con un intervalo conservador, es muy probable que aparezca un patrón claro de deriva después de tres calibraciones. Por ejemplo, un transmisor RTD concreto se calibra cada tres meses. La segunda calibración indica una deriva con un error máximo de +0,065% del span. La tercera calibración indica otro +0,060% del span (+0,125% del span en 6 meses). Aunque se deberían utilizar más datos para el análisis, se podría suponer que este instrumento tiene una deriva de +0,25% anual. Estadísticamente, más datos es igual a un mayor nivel de confianza. Si este comportamiento es común a muchos transmisores RTD de la misma marca/modelo utilizados en la planta, el intervalo adecuado para una tolerancia de ±0,50% del span podría establecerse entre 18 y 24 meses con un nivel de confianza muy alto.

Al recopilar datos sobre la calibración, es fundamental que no se realicen ajustes innecesarios. Por ejemplo, si la tolerancia es ±1% del span y el instrumento solo se desvía en un -0,25% del span, no se debería realizar ningún ajuste. ¿Cómo se puede analizar la deriva si se realizan ajustes constantemente? Para determinadas personas, no ajustar puede suponer un reto, no obstante, cada vez que se realiza un ajuste, el análisis de la deriva se ve comprometido. Una buena práctica sobre los patrones de un laboratorio de metrología es posponer el ajuste hasta que la deriva supere 2/3 partes del límite de tolerancia establecido (es decir, ±0,67% de la tolerancia). Una buena práctica es hacer lo mismo con los equipos de medida. Esto puede resultar difícil para un ingeniero de control conservador, no obstante, un nivel de ajuste de menos de 1/2 de tolerancia comprometerá el análisis de la deriva.

¿Qué ocurre si la deriva es contradictoria, es decir, creciente y decreciente en el tiempo? Harán falta más análisis; por ejemplo, ¿son las condiciones ambientales extremas o cambian constantemente? Dependiendo de la aplicación del proceso, el rendimiento del instrumento puede verse afectado por el medio, la instalación, las turbulencias u otras variables. Esta situación indica que existe un nivel de «ruido» asociado con la desviación. En estos casos, el análisis debería mostrar que existe una combinación de error aleatorio y error sistemático. El error aleatorio está formado por aspectos incontrolables (condiciones ambientales y aplicación del proceso) mientras que el error sistemático consiste en aspectos identificables (deriva del instrumento). Centrándose en el error sistemático y/o en patrones claros de deriva, se puede establecer un intervalo adecuado de calibración para maximizar la eficiencia operativa de la manera más segura posible.

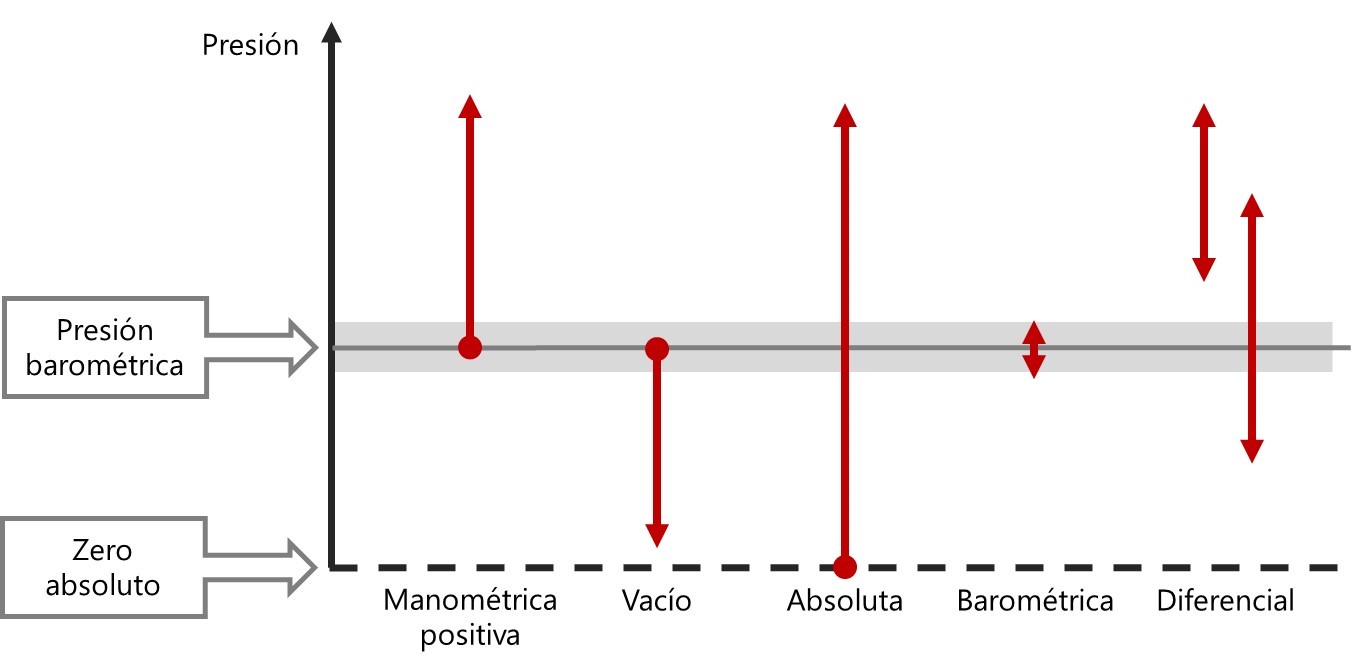

Establecer la tolerancia del proceso y los límites de error adecuados

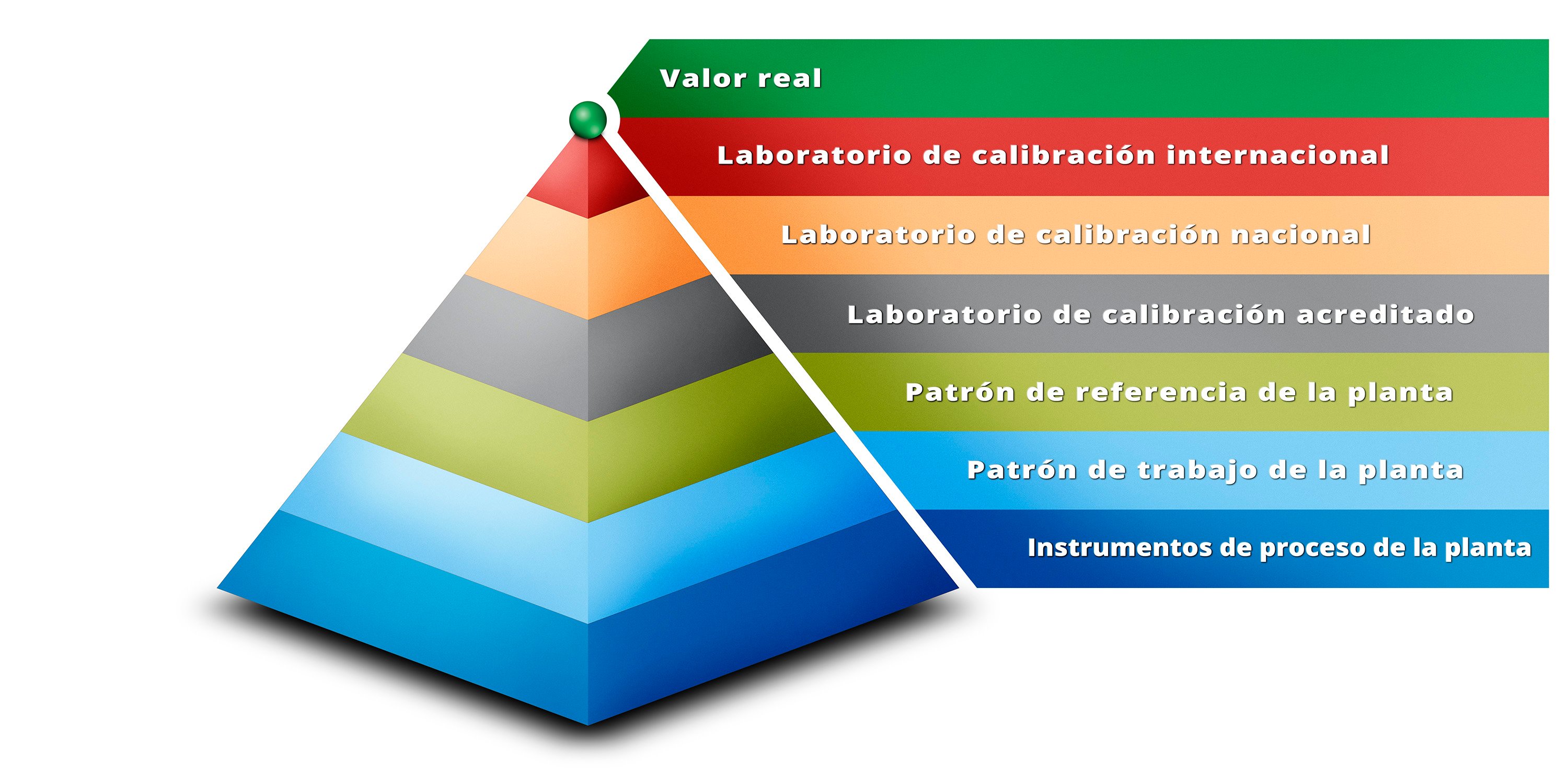

Exactitud, Tolerancia del Proceso, Error de rechazo, Límite de error, Error permitido, Desviación, etc., son algunos de los principales términos utilizados para especificar el rendimiento de un instrumento en un proceso determinado. Los fabricantes de transmisores siempre especifican la exactitud (accuracy) junto con algunos otros parámetros asociados al error (estabilidad a largo plazo, repetibilidad, histéresis, patrón de referencia y más). Cuando se quiere establecer una tolerancia del proceso, la exactitud publicada por el fabricante ofrece un punto de partida, aunque no siempre es un número fiable. Además, ninguna medida realizada superará la propia especificación del patrón utilizado para la calibración del instrumento. ¿Qué hay detrás de la declaración de exactitud de un fabricante de un instrumento cuyas especificaciones reflejan un buen nivel de exactitud? Con respecto a la presión, una buena balanza de pesos muertos en un laboratorio debería formar parte de la fórmula. En una planta industrial, una conocida regla de oro es tener una ratio 4:1 para la incertidumbre del calibrador (error total) frente a la tolerancia del equipo de medida.

Al establecer una tolerancia del proceso, una buena práctica es preguntar al ingeniero de control cuál es la tolerancia óptima para obtener el mejor rendimiento del proceso y para fabricar el mejor producto de la forma más segura posible. Teniendo en cuenta que cuanto menor sea el número, mayores serán los costes de calibración. Para conseguir cumplir con una tolerancia exigente, será necesario disponer de unos buenos patrones de calibración. Además, otro aspecto es determinar si la calibración debe realizarse en campo o en el taller. Si la instrumentación presenta derivas, será necesario establecer un intervalo más frecuente para poder detectar un error en la medida. Ello puede significar un aumento del tiempo de parada junto con los costes asociados a las calibraciones reales. A modo de ejemplo, vamos a revisar las tres gráficas de calibración del instrumento:

%20-%20ESP.jpg?width=935&name=Graph%201%20(0.1%25)%20-%20ESP.jpg)

%20-%20ESP.jpg?width=935&name=Graph%202%20(0.25%25)%20-%20ESP.jpg)

%20-%20ESP.jpg?width=935&name=Graph%203%20(1%25)%20-%20ESP.jpg)

Se puede observar, que la primera gráfica muestra un error (casi el doble del valor permitido), la segunda muestra que hace falta un ajuste (sobrepasa por un poco los límites de ajuste) y la tercera muestra los resultados de calibración de un transmisor relativamente buenos. Los datos de la calibración son idénticos en las 3 gráficas, la única diferencia es la tolerancia. Establecer una tolerancia muy ajustada o exigente de ±0,1% del span, puede provocar varios problemas: lidiar o tener que justificar con informes de calibración “No aceptados”, los ajustes constantes añaden estrés al técnico de calibración, operaciones no confía en las mediciones, entre otras. La gráfica nº 2 no es mucho mejor, el error no supera el límite, pero un 0,25% de span continúa siendo una tolerancia muy estricta y un ajuste constante no permitirá el análisis de deriva ni la evaluación del error aleatorio o el error sistemático. En la gráfica nº 3 aparecen muchas ventajas (se puede observar que ±1% de span continúa siendo una tolerancia estricta). En caso de que el resultado fuese “No aceptado”, sería un problema inusual y probablemente grave. El técnico de calibración pasará menos tiempo alterando el proceso y el tiempo de calibración total será menor ya que hay menos ajustes. Un patrón adecuado está disponible a un precio razonable pudiendo conseguir una especificación de rendimiento de ±1% del span.

Es posible que haya medidas críticas que requieran una tolerancia exigente y que, como consecuencia, aumenten los costes necesarios, no obstante, se pueden tomar buenas decisiones si se tienen en cuenta los verdaderos requisitos del rendimiento en comparación con los costes asociados. Escoger un número arbitrario que sea inexplicablemente ajustado puede provocar más problemas de los necesarios y aumentar el estrés a niveles incontrolables. El mejor método sería establecer una tolerancia lo más alta posible, recopilar algunos datos de rendimiento y entonces, reducir la tolerancia basándose en el intervalo adecuado para conseguir los resultados óptimos.

¿Se pueden optimizar los procedimientos y los métodos?

Un detalle sutil e importante a la vez, es revisar los procedimientos de calibración para ver si se puede conseguir una mayor eficiencia sin afectar la calidad de los datos. Hace años, la tecnología era más mecánica, con más componentes y más complejos, y los instrumentos eran más sensibles a las condiciones ambientales. Hoy en día, la tecnología ofrece una mejor exactitud y «mayor inteligencia» con menos componentes que, además, simplifican y cuentan con mejores capacidades de compensación. En muchos casos, los viejos hábitos de calibración no han evolucionado al mismo ritmo que la tecnología. Un buen ejemplo es un antiguo sensor de presión relativa que al empezar desde cero e ir aumentando la presión «se desvía» hacía el extremo inferior debido al estado de “relajación” inicial. De igual modo, cuando el elemento sensor pasa a recibir la máxima presión y esta decrece, un vicio mecánico «desvía» la presión que está midiendo hacia el extremo superior. Este fenómeno se denomina histéresis y gráficamente se parecería a la gráfica nº 4 cuando se realiza una calibración.

%20-%20ESP.jpg?width=935&name=Graph%204%20(with%20hys)%20-%20ESP.jpg)

Los sensores de presión inteligentes de hoy en día han mejorado mucho y la histéresis solo ocurrirá si algo no funciona bien en el sensor o si este ha sido dañado. Si la misma calibración se realiza en un sensor moderno, la representación gráfica típica tendría el aspecto de la gráfica nº5.

%20-%20ESP.jpg?width=935&name=Graph%205%20(no%20hys)%20-%20ESP.jpg)

Esto puede parecer simple, pero requiere un esfuerzo significativo para el técnico de calibración a la hora de realizar una calibración de presión con una bomba de mano. Comprobar el cero es fácil, pero la práctica habitual es invertir el esfuerzo en conseguir la presión exacta para calcular el error estimado basado en la señal de mA. Por ejemplo, si se supone que a 25 inH20 es exactamente 8 mA, pero se observan 8,1623 mA cuando la presión se establece exactamente a 25 inH20, un técnico experimentado sabe que se encuentra ante un error de 1% de span (0,1623 ÷ 16 x 100 = 1%). Este esfuerzo extra para conseguir un punto de calibración conocido puede necesitar mucho tiempo, especialmente a una presión muy baja de 25 inH20. Realizar una calibración de 9 puntos, puede llevar 5 minutos o más, y hace que esta calibración de ejemplo sea innecesariamente más larga. Se puede realizar una calibración de 5 puntos y reducir el tiempo a la mitad. La gráfica tendría el mismo aspecto ya que los puntos de calibración bajando no añaden información nueva. No obstante, un sensor de presión sigue siendo mecánico y, como ya se ha mencionado, podría presentar histéresis. Una buena práctica sería realizar una calibración de un transmisor de presión con 3 puntos subiendo y bajando. La calidad de los datos de los puntos de calibración es equivalente a una calibración de 8 puntos y en caso de que hubiera histéresis, se detectaría. Esto también supone menos estrés para el técnico ya que solo hay 3 puntos de calibración «difíciles» (el cero es fácil) en comparación con los 4 puntos en una calibración de 5 puntos y 7 para una calibración de 9 puntos subiendo y bajando. El ahorro de tiempo puede ser significativo y, además, facilitará el trabajo diario de los técnicos.

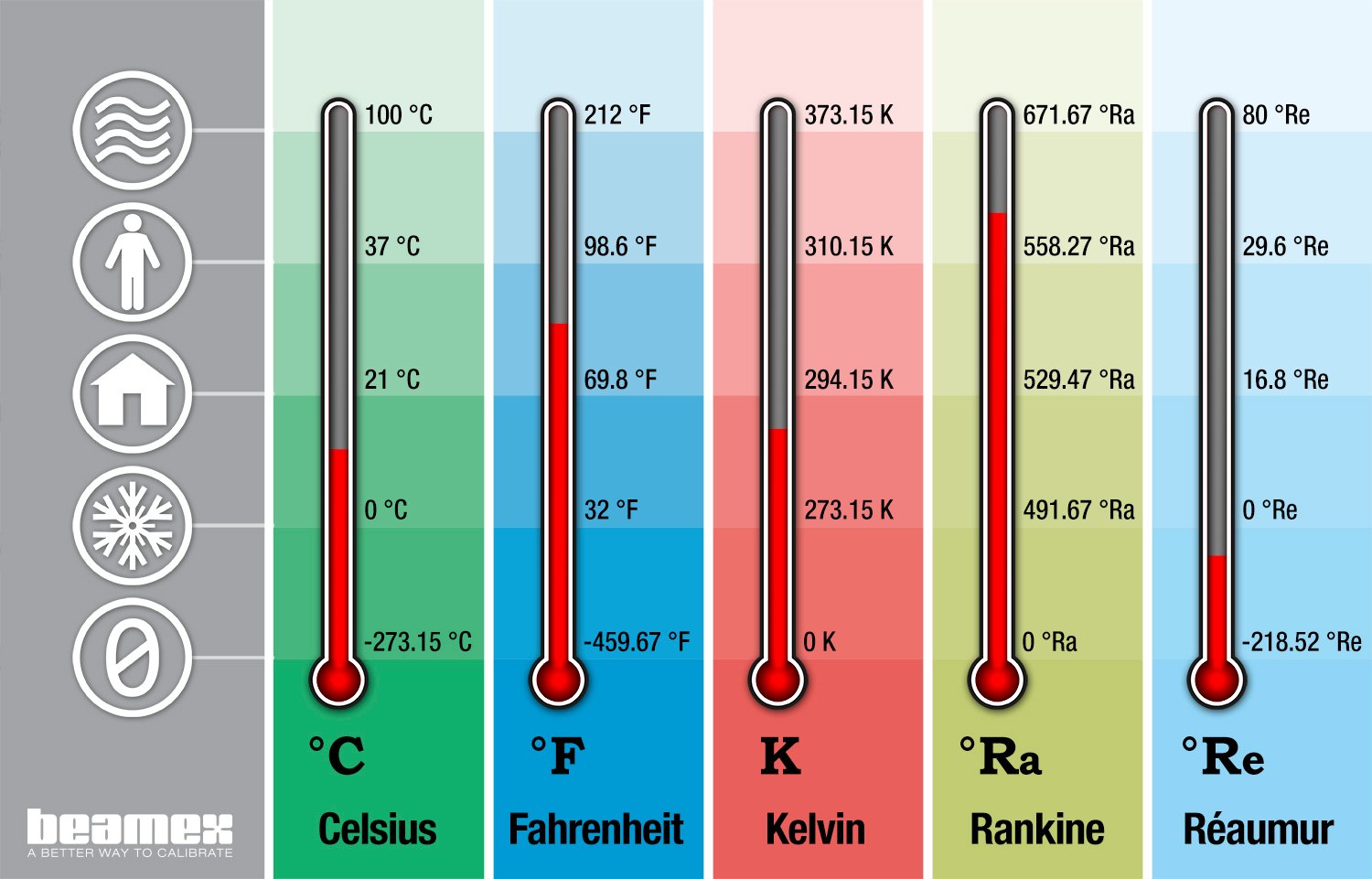

Este mismo método también se puede aplicar a los equipos de medida de temperatura. Un sensor de temperatura (RTD o termopar) es electromecánico y normalmente no presenta histéresis. Todo el comportamiento que tenga cuando la temperatura suba, es repetible cuando la temperatura baje. El fenómeno más frecuente es la «variación de cero» o «repetibilidad en el cero» que es indicativo de un choque térmico o un daño físico (contacto brusco con el proceso o caída). Un transmisor de temperatura es un dispositivo electrónico y, con la moderna tecnología inteligente, presenta unas excelentes propiedades de medición. En consecuencia, una buena práctica para la instrumentación de temperatura es realizar una calibración simple de 3 puntos. Si se calibra una sonda de temperatura en un bloque seco o en un baño líquido, realizar más de 3 puntos es una pérdida de tiempo salvo que los requerimientos de exactitud sean elevados o haya otras razones prácticas para analizar más puntos.

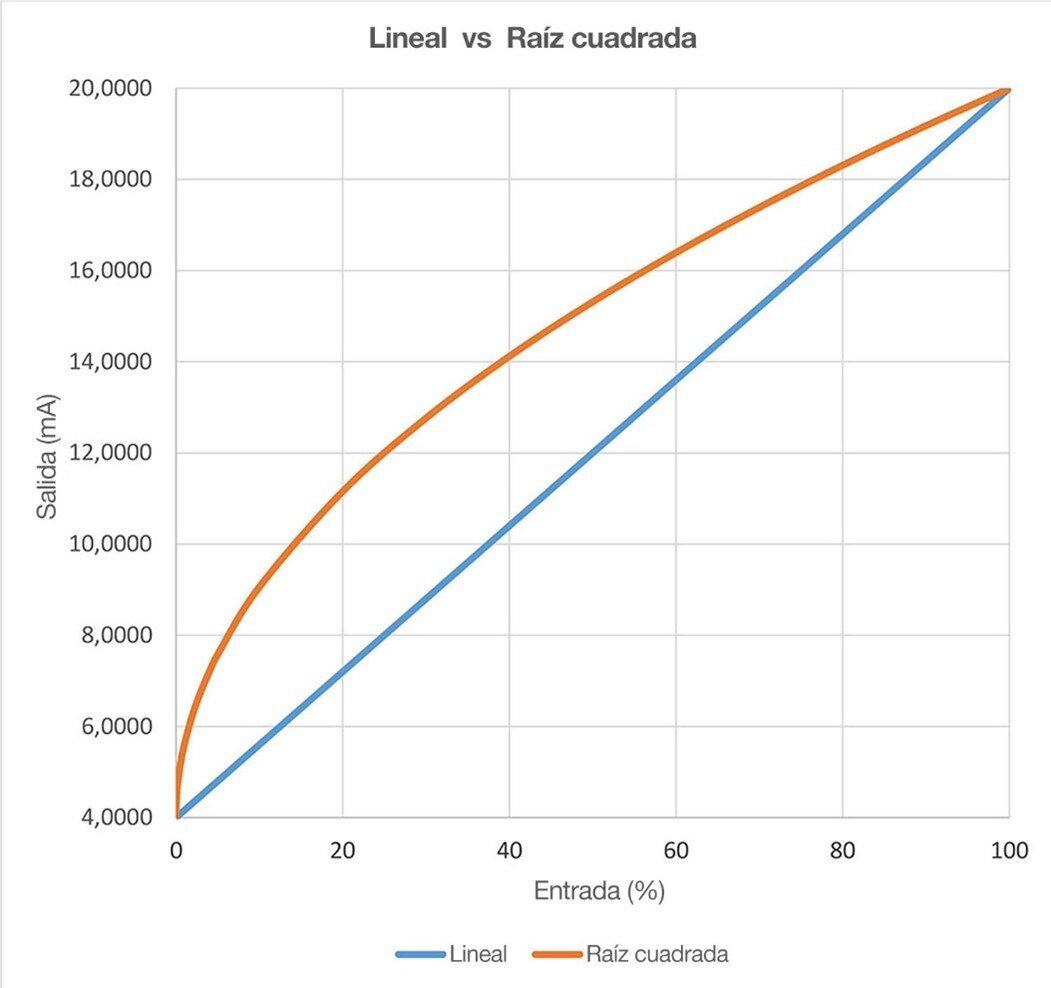

Existen otros ejemplos de optimización de los procedimientos y métodos de calibración. Las calibraciones tienen que estar relacionadas con el proceso; si el proceso no baja de los 100 ºC, ¿por qué realizar un punto de calibración a cero? Cuando se utiliza un bloque seco, puede tardar mucho tiempo en alcanzar un punto de calibración de 0 ºC o inferior a este. ¿Por qué no establecer un punto de calibración inicial de 5 ºC con una salida esperada de 4,8 mA, por ejemplo, si es más práctico, ahorra tiempo y hace que la calibración sea más fácil? Otro buen ejemplo es realizar una calibración de un transmisor de presión diferencial con extracción de raíz cuadrada cuya aplicación es la medida de caudal. Como se está midiendo un caudal, los puntos de calibración de salida deberían ser 8 mA, 12 mA, 16 mA y 20 mA, no basados en los puntos concretos de la presión de entrada. Además, esta tecnología emplea un «low flow cut-off» donde no se puede medir un caudal muy bajo. Una buena práctica es realizar un punto de calibración inicial de 5,6 mA de salida (que es muy cercano al cero, a solo el 1% del span de entrada).

No hay que pasar por alto cómo se ha realizado la calibración y su análisis. ¿Por qué recoger datos innecesarios? Representa más información a procesar y puede suponer un coste importante. ¿Por qué hacer más difícil el trabajo de calibración? Es importante revisar los datos históricos de las calibraciones y tomar decisiones que simplifiquen el trabajo sin sacrificar la calidad.

Análisis de la tendencia de los resultados de las calibraciones y costes

Ejemplo de un transmisor de temperatura

Como se ha mencionado, la mejor manera de optimizar la planificación de la calibración es analizar los datos históricos. Existe un equilibro entre el rendimiento del proceso, la deriva del instrumento, la tolerancia, el intervalo adecuado, el coste de la calibración, y la única manera de determinarlo es a través del análisis de los datos históricos. Tras lo expuesto en el apartado “Establecer la tolerancia del proceso y los límites de error adecuados”, es posible aplicar los conceptos sobre los resultados históricos de calibración del transmisor de temperatura para optimizar el intervalo de calibración mostrado en este escenario (Gráfica nº 6):

%20-%20ESP.jpg?width=1033&name=Graph%206%20(History)%20-%20ESP.jpg)

Tras una conversación entre el Ingeniero de control y el grupo de Mantenimiento I&C, se estudió un caso para reducir la tolerancia al ±0,5% del span, sin embargo, se acordó mantener un ±1% del span por el momento, ya que sería aceptable hasta que se obtuviera más información. Esta medida en particular es crítica, por lo que también se acordó realizar calibraciones periódicas cada 3 meses hasta que se obtuviera más información. Al final del primer año, se observó una deriva de aproximadamente ±0,25% del span, sin realizar ningún ajuste. Tras posteriores reuniones, se acordó reducir la tolerancia al ±0,5% del span (el Ingeniero de control se sintió muy satisfecho) y aumentar el intervalo a 6 meses. Finalmente, se realizó un ajuste un año y medio después de la calibración inicial. Al final del segundo año, no hizo falta ningún ajuste y el intervalo se aumentó a 1 año. Al final del tercer año, se hizo un ajuste y el intervalo se aumentó a 18 meses (ahora el Director de planta, el Supervisor de I&C y los Técnicos de I&C están muy satisfechos). Todo esto tuvo lugar sin ninguna incidencia que pudiera requerir una notificación especial u otros quebraderos de cabeza.

Obviamente, esta situación es perfecta, si hay muchos instrumentos de la misma marca/modelo, se mostrarán sólidas tendencias con buenos datos históricos que confirmarán las buenas prácticas y permitirán tomar mejores decisiones. En caso de mediciones de instrumentos críticos, la mayoría de los ingenieros se muestran conservadores y prefieren «pasarse» con la calibración. Este ejemplo podría abrir una discusión sobre como trabajar de forma más inteligente, ahorrar tiempo/energía y mantener un entorno seguro sin comprometer la calidad.

Coste de la calibración

Otra buena práctica es, siempre que sea posible, intentar establecer el coste de la realización de una calibración concreta e incluirlo en el proceso de la toma de decisiones. No considerar únicamente las horas del operario, sino el coste del equipo de calibración, así como los costes de la recalibración anual del mismo. Al hablar de intervalos y tolerancia, esta información puede resultar muy importante a la hora de tomar una buena decisión. No se pueden realizar buenas mediciones con un equipo de calibración mediocre. A modo de ejemplo, para cumplir con una tolerancia de medición de presión especialmente ajustada, se debe utilizar una balanza de pesos muertos en lugar de un calibrador de presión convencional. Este es un gran paso en cuanto a coste del equipo y la experiencia/ formación del técnico. Conociendo los costes adicionales asociados a una medición de este tipo, se podría conseguir un buen compromiso determinando los beneficios y los riesgos de realizar calibraciones más frecuentes con un equipo de menor exactitud, o utilizar equipos de calibración alternativos.

Otro coste operativo que se pasa por alto es la necesidad fundamental de invertir en personal y equipamiento. Con las nuevas tecnologías o nuevos equipos de calibración, el mantenimiento y/o los procedimientos de calibración se verían reforzados con una buena formación. ISA ofrece diversas opciones de formación excelentes, y habría que tener en cuenta los programas locales disponibles para los técnicos de calibración a través de escuelas profesionales o seminarios industriales. Finalmente, se debería hacer una revisión de los equipos de calibración cada año para justificar una reinversión por sustitución del equipo antiguo. La recalibración anual puede ser cara, por lo que al escoger un nuevo equipo de calibración, conviene escoger un dispositivo que pueda sustituir a varios de ellos.

Otro coste importante a tener en cuenta es el de los fallos. ¿Qué ocurre cuando un instrumento crítico falla? En caso de auditorías o posibles problemas de parada, es fundamental contar con un buen programa de calibración y detectar los problemas antes de que empiecen, a fin de evitar un proceso de recuperación largo y costoso. Si el equipo de calibración vuelve con un módulo averiado, ¿cuál es el impacto potencial sobre todas las calibraciones realizadas por ese módulo en el año anterior? Entendiendo estos riesgos y los costes asociados, se pueden tomar decisiones y realizar las inversiones correctas.

Conclusión

Obviamente, no todos los instrumentos van a ofrecer un análisis fácil para predecir las derivas. Además, los programas de calibración se interrumpen y muchas veces se debe trabajar durante una parada no programada, aunque se haya hecho una buena planificación. En algunas áreas existen requerimientos regulados, normativas o sistemas de calidad que especifican con qué frecuencia se deben calibrar los instrumentos. Es difícil razonar con estos auditores. Una buena práctica es establecer un buen programa, centrado en los instrumentos más críticos. Cuando los instrumentos críticos están bajo control, se dispone de más tiempo para pasar al siguiente nivel de criticidad, y así sucesivamente.

En un buen programa de gestión de calibración se deberían utilizar estrategias alternativas o «híbridas». Por ejemplo, la calibración de lazos puede reducir los costes, ya que la calibración es realizada agrupadamente entre el primer elemento del lazo y el último, y únicamente calibrar el instrumento de manera individual cuando el lazo no exista. Una buena estrategia «híbrida» es realizar una planificación de calibración «ligera» combinada con otras más «en profundidad» que pueden ser menos frecuentes. A modo de ejemplo, realizar un «control puntual» mínimamente invasivo (normalmente, a un punto) que tenga una menor tolerancia de lo normal (se puede usar el 2/3 recomendado del valor de tolerancia normal). En caso de que el «control puntual» falle, el procedimiento estándar sería realizar una calibración en profundidad para realizar los ajustes necesarios. Un técnico puede tener una ruta de 10 «controles puntuales» y finalmente, realizar solo 1 ó 2 calibraciones en profundidad en toda la ruta. La realización de los «controles puntuales» también se debe documentar y realizar el seguimiento, ya que es posible obtener buena información sobre las derivas a partir de este tipo de datos.

A modo de resumen, se han citado varias buenas prácticas:

- Establecer un intervalo de calibración conservador basado en cuál sería el impacto de un fallo en términos de funcionamiento de manera segura, mientras se fabrica un producto con la máxima eficiencia y calidad

- No ajustar hasta que la especificación de tolerancia se sitúe por encima del 2/3 (o ±0,67% con una tolerancia de ±1% del span); esto puede resultar difícil para un ingeniero de control conservador, no obstante, un nivel de ajuste de

menos de 1/2 de tolerancia comprometería el análisis de la deriva. - Preguntar al ingeniero de control cual es la tolerancia del rendimiento del proceso requerida para fabricar el mejor producto de la forma más segura posible.

- Establecer una tolerancia lo más alta posible, recopilar algunos datos de rendimiento y entonces, reducir la tolerancia basándose en el intervalo óptimo para conseguir los resultados adecuados

- Realizar una calibración subiendo y bajando de 3 puntos en un transmisor de presión; la calidad de los datos de los resultados es equivalente a una calibración de 9 puntos y en el caso de que hubiera histéresis, se detectaría.

- Realizar una calibración simple de 3 puntos en la instrumentación de temperatura. Si se calibra una sonda en un bloque seco o en un baño líquido, analizar más de 3 puntos es una pérdida de tiempo salvo que los requisitos de exactitud sean elevados o haya otras razones prácticas para analizar más puntos.

- Realizar una calibración de un transmisor de presión diferencial con extracción de la raíz cuadrada destinado a medir caudal en un punto de calibración inicial de 5,6 mA de salida (que es muy cercano al cero a solo el 1% del span de entrada). Además, cómo se está midiendo un caudal, los puntos de calibración de salida deberían ser 8 mA, 12 mA, 16 mA y 20 mA, no basados en puntos concretos de la presión de entrada.

- Siempre que sea posible, definir el coste de una calibración en concreto e incluirlo en el proceso de la toma de decisiones.

- Centrarse en los instrumentos más críticos, establecer un buen programa y cuando los instrumentos críticos están bajo control, se dispone de más tiempo para pasar al siguiente nivel de criticidad, y así sucesivamente.

Siempre tener en cuenta que los instrumentos derivan, y que algunos tienen un rendimiento mejor que otros. La configuración de la tolerancia determinará, finalmente, el plan de calibración. Mediante el análisis de resultados, si existiera la posibilidad de distinguir entre el error sistemático (deriva) del error aleatorio («ruido») y se observara un patrón sistemático, se podría determinar un intervalo de calibración adecuado. La mejor combinación tolerancia/intervalo proporcionará buenos datos de control para conseguir la mejor eficiencia, calidad, seguridad y los menores costes de calibración minimizando incidencias de auditorías y menos quebraderos de cabeza. Establecer las mejores prácticas de calibración debería ser una evolución continua. La tecnología cambia y las calibraciones deberían evolucionar paralelamente a ella. Como se ha comentado, existen muchas variables implicadas en la realización correcta de las calibraciones. Estableciendo un plan de calibración básico, similar al comportamiento observado en el entorno operativo, se pueden tomar decisiones inteligentes

(y modificarlas) para trabajar a niveles adecuados.

Descarga gratis este artículo haciendo clic en la siguiente imagen:

Entradas de blog relacionadas

Publicación original: Optimal Calibration Parameters for Process Instrumentation

Publicado en: Abril 2019

.png)

Enviar una respuesta